Google hat ein neues Kapitel seiner KI-Strategie aufgeschlagen – und zwar eines, das sich nicht mit „ein bisschen intelligenter“ oder „etwas schneller“ beschreiben lässt. Mit Gemini 3 startet der Konzern eine Modellgeneration, die in mehreren Disziplinen große Sprünge macht, in manchen sogar neue Maßstäbe setzt. Und anders als viele Tech-Ankündigungen der vergangenen Jahre, die mit Superlativen um sich werfen, liefert Gemini 3 erstaunlich viele harte Fakten, die diesen Anspruch untermauern.

Sundar Pichai formuliert es in seiner Einleitung fast ungewohnt offen: Zwei Jahre nach dem Start der Gemini-Ära habe man Milliarden Menschen erreicht, Millionen Entwickler*innen eingebunden und die Plattform komplett durchoptimiert. Nun beginne ein Abschnitt, in dem KI nicht nur reagiert, sondern vorausschauend denkt, abstrahiert und komplexe Aufgaben tatsächlich strukturiert ausführt. Sein Fazit: „Es ist erstaunlich, wie schnell KI in nur zwei Jahren gelernt hat, zwischen den Zeilen zu lesen.“

Was das bedeutet, zeigt sich besonders an Gemini 3 Pro, der ersten verfügbaren Version der neuen Reihe – und die steht ab sofort weltweit bereit.

Ein Modell, das Benchmarks neu sortiert

Dass Google stolz auf diese Generation ist, überrascht nicht, schließlich setzt Gemini 3 gleich mehrere Rekorde. Im Reasoning-Bereich, also der Fähigkeit der KI, logisch zu schließen und nicht nur Text vorherzusagen, liegt das Modell in nahezu jedem wichtigen Test vorne. Besonders eindrucksvoll ist der Sprung beim anspruchsvollen „Humanity’s Last Exam“, bei dem Gemini 3 Pro auf 37,5 Prozent kommt – ein Wert, der nicht nur die Vorgänger, sondern auch GPT-5.1 deutlich hinter sich lässt.

Auch bei wissenschaftlichem Schlussfolgern (GPQA Diamond), in mathematischen Wettbewerben oder in multimodalen Aufgaben, bei denen Text, Bild und Video gemeinsam verarbeitet werden, setzt das Modell neue Höchstwerte. Das alles zeigt, dass Google nicht einfach an einzelnen Stellschrauben gedreht hat, sondern sein System grundlegend weiterentwickeln konnte.

Besonders bemerkenswert ist zudem, wie viel Wert der Konzern auf faktische Korrektheit gelegt hat. Die neue Generation soll deutlich weniger Fehler machen, zuverlässiger mit Quellen umgehen und sich in kritischen Bereichen seltener „verrannt“ äußern. In der Praxis zeigt sich das in direkteren, nuancierteren Antworten – weniger höfliche Plauderei, dafür mehr Substanz.

Ein bewusster Bruch mit dem Trend zur „menschlichen KI“

Während OpenAI zuletzt vor allem versucht hat, KI „menschenähnlicher“ wirken zu lassen, geht Google einen spürbar anderen Weg. Koray Kavukcuoglu, einer der verantwortlichen DeepMind-Manager, fasst es so zusammen: „Keine Schleimerei, keine Klischees, keine Ablenkungen. Gemini 3 soll echte Insights liefern.“

Tatsächlich wirken die Antworten der neuen Modelle konzentrierter, präziser und analytischer. Google will sich bewusst von der Vorstellung verabschieden, dass KI ein digitaler Kumpel sein soll, der gute Laune verbreitet. Stattdessen positioniert man Gemini 3 als einen Partner, der hilft, Probleme zu durchdenken, Entscheidungen zu strukturieren und neue Ideen zu entwickeln – eine Art erweitertes Gehirn, nicht ein digitaler Freund.

Deep Think: Der Modus für die wirklich harten Brocken

Obwohl Gemini 3 Pro bereits im Alltag überzeugen soll, hat Google noch eine zweite Variante angekündigt: Gemini 3 Deep Think. Dieser Modus, der in einigen Benchmarks noch einmal deutlich bessere Werte erzielt, ist darauf ausgelegt, extrem schwierige logische Aufgaben zu lösen. Für Google AI Ultra-Abonnent*innen wird Deep Think voraussichtlich in den kommenden Wochen verfügbar sein – aktuell durchläuft er eine zusätzliche Sicherheitsprüfung.

Die Fähigkeiten sind beeindruckend: In Tests, die traditionell eher schwache Ergebnisse liefern, erreicht Deep Think Werte, die vor wenigen Monaten kaum vorstellbar waren. Das gilt besonders für Reasoning-Benchmarks wie ARC-AGI, die als Proxy für echte Allgemeine Intelligenz gelten. Dass Google diesen Modus separat anbietet, zeigt auch, wie rechenintensiv diese Schlussfolgerungsleistung inzwischen geworden ist.

Multimodalität, die mehr kann als nur „Bild plus Text“

Gemini 3 ist von Grund auf für multimodales Arbeiten entwickelt – und zwar nicht als Add-on, sondern als zentrales Funktionsprinzip. Das Modell verarbeitet Text, Bilder, Videos, Audio und Code nicht einfach nebeneinander, sondern versteht Zusammenhänge dazwischen.

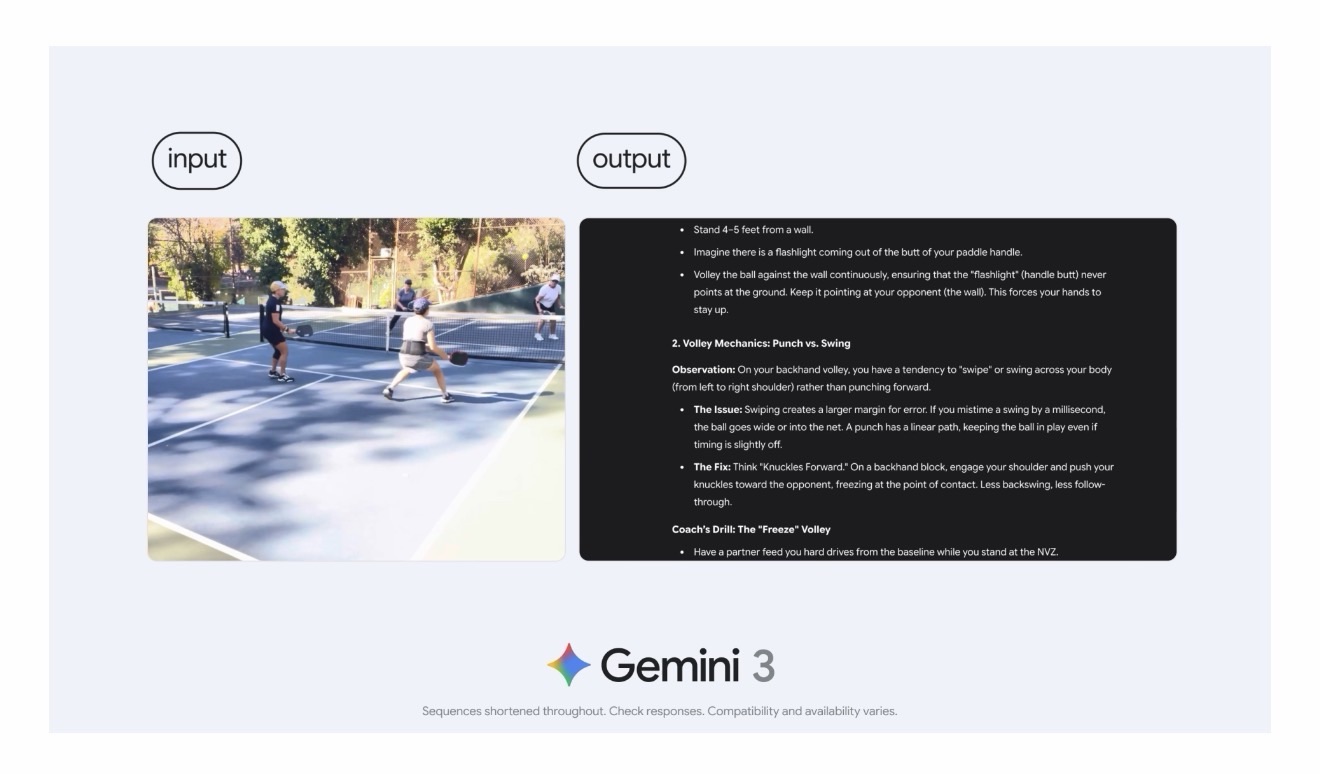

Das zeigt sich besonders in den neuen Lernfunktionen. Die KI kann beispielsweise handgeschriebene Rezepte aus verschiedenen Sprachen erkennen, zusammenführen und in ein vollständiges Kochbuch verwandeln. Sie kann lange wissenschaftliche Vorträge analysieren, daraus interaktive Lernkarten generieren oder für komplexe biologische Prozesse sofort dynamische Visualisierungen erstellen. Wer Sportvideos hochlädt – Google nennt konkret Pickleball -, bekommt nicht nur eine qualitative Analyse, sondern einen strukturierten Trainingsplan, der Schwachstellen adressiert.

Hier zeigt sich ein Paradigmenwechsel: KI wird mehr und mehr zu einem Werkzeug, das Wissen nicht nur wiedergibt, sondern verarbeitet, strukturiert und neu formt.

Generative User Interfaces: Die Antwort ist jetzt selbst die Anwendung

Einer der spannendsten Schritte ist die Einführung sogenannter generativer UIs. Google will die starre Grenze zwischen KI-Antwort und Anwendung auflösen. Statt nur Text zurückzugeben, erzeugt Gemini 3 künftig interaktive Oberflächen, Visualisierungen oder Tools direkt in der Antwort. Bei Reiseplanungen entstehen dynamische Layouts, bei wissenschaftlichen Fragen interaktive Diagramme, bei Umrechnungen kleine Tools, die sofort nutzbar sind. Besonders in der Suche soll das einen enormen Unterschied machen: Wenn Nutzer*innen künftig eine komplexe Frage stellen, kann die KI nicht nur erklären, sondern auch simulieren und visualisieren – und zwar innerhalb der Suchansicht.

Noch ist das nur in den USA aktiv, doch Google plant eine zügige internationale Ausrollung.

Gemini 3 wird zum Coder – und zum Co-Entwickler

Im Bereich Softwareentwicklung macht Gemini 3 ebenfalls einen großen Sprung. Das Modell beherrscht nicht nur Zero-Shot-Generierung für Web-Oberflächen, sondern kann auch komplexe Codebasen verstehen, refaktorieren, testen und erweitern. Die Modellgeneration erzielt Bestwerte in Benchmarks wie der WebDev Arena oder Terminal-Bench 2.0, und wer schon mit Gemini 2.5 gearbeitet hat, merkt sofort: Die neue Version ist nicht nur schneller und genauer, sondern vor allem selbstständiger.

Damit sind wir beim wohl spannendsten neuen Produkt, das Google parallel eingeführt hat: Google Antigravity.

Antigravity: Eine Entwicklungsumgebung, die mitdenkt

Google nennt es eine „agentische Entwicklungsplattform“ – und tatsächlich fühlt sich Antigravity wie ein Blick in die Zukunft der Softwareentwicklung an. Statt bloß Code vorzuschlagen oder zu vervollständigen, fungiert die KI als aktiver Partner. Sie nimmt Aufgaben entgegen, zerlegt sie in Teilprobleme, schreibt Code, führt ihn aus, testet ihn, verbessert ihn und dokumentiert den Fortschritt. Entwickler*innen können jederzeit eingreifen oder dem System freie Hand lassen. Besonders spannend: Antigravity lernt den individuellen Coding-Stil und passt seine Strukturierung daran an – eine der größten Schwachstellen klassischer KI-Codetools.

Und: Die Plattform ist offen. Neben Gemini 3 funktionieren auch Claude Sonnet oder OpenAI-Modelle. Das ist ein bemerkenswerter Schritt für Google, der zeigt, wie wichtig der Konzern die eigene Entwicklerbasis nimmt.

Planung auf Langstrecke: KI, die ein Jahr vorausdenkt

Gemini 3 soll Aufgaben nicht nur verstehen, sondern auch über lange Zeiträume durchziehen. In der neuen Vending-Bench 2, einer Simulation eines digitalen Automaten-Business über ein Jahr, liegt das Modell klar vorne. Das mag abstrakt klingen, zeigt aber eine Fähigkeit, die für Agenten entscheidend ist: Langzeitkonsistenz.

Google nutzt genau das, um erstmals einen Gemini Agent bereitzustellen – zunächst experimentell, mit Fokus auf Ultra-Abos. Dieser kann alltägliche Aufgaben übernehmen, beispielsweise das Gmail-Postfach systematisch aufräumen, Buchungen durchführen oder komplexe Workflows autonom abarbeiten. Immer unter der Kontrolle der Nutzer*innen, aber spürbar selbstständiger als bisherige KI-Assistenten.

Sicherheit: Der vielleicht wichtigste Fortschritt

Google betont, dass Gemini 3 das sicherste Modell sei, das das Unternehmen je gebaut hat. Die Prüfung war umfangreicher als bei jeder vorherigen KI-Generation. Besonders hervorgehoben werden Schutzmechanismen gegen Missbrauch, gegen Prompt-Injection und eine geringere Tendenz zum unreflektierten „Ja-Sagen“. Externe Institute wie das UK AI Safety Institute sowie unabhängige Sicherheitsfirmen waren ebenfalls beteiligt. Insbesondere für die kommende Deep-Think-Variante legt Google einen strengen Review-Prozess an.

Fazit: Ein Statement von Google – und ein ernstzunehmender Schritt in Richtung KI-Agenten

Mit Gemini 3 zeigt Google, dass es auf Augenhöhe mit der Konkurrenz bleibt – und diese in manchen Bereichen sogar überholt hat. Die Modellgeneration ist nicht einfach klüger, sondern funktional umfassender. Sie denkt analytischer, schreibt besseren Code, versteht Medien nahtloser und führt erstmals echte agentische Aufgaben über längere Zeiträume durch. Vielleicht beginnt tatsächlich eine „neue Ära“. Nicht, weil Google es sagt, sondern weil sich mit Gemini 3 abzeichnet, dass KI langsam den Sprung von der Antwortmaschine zum aktiven Problemlöser macht.

Gemini 3 Pro ist erst der Start. Weitere Versionen folgen – schnell, wenn man Googles aktuellen Rhythmus kennt. Zudem stehen neue Generationen der kleineren Flash- und Nano-Modelle an, darunter wahrscheinlich eine Fortsetzung des humorvoll benannten Bildmodells „Nano Banana“. Die Hinweise im Launch-Video deuten zumindest darauf hin. Google sieht sich in einer starken Position: Mit eigenem Modell-Stack, eigener Hardware und eigener Software will man künftig schneller iterieren und breitere Nutzergruppen erreichen. Die bisherigen Nutzungszahlen – rund 650 Millionen monatlich aktive Gemini-User – geben dem Unternehmen offenbar Rückenwind.

mehr zu Google & Co